记录一次爬取淘宝/天猫评论数据的过程

By 苏剑林 | 2015-05-06 | 206543位读者 |笔者最近迷上了数据挖掘和机器学习,要做数据分析首先得有数据才行。对于我等平民来说,最廉价的获取数据的方法,应该是用爬虫在网络上爬取数据了。本文记录一下笔者爬取天猫某商品的全过程,淘宝上面的店铺也是类似的做法,不赘述。主要是分析页面以及用Python实现简单方便的抓取。

笔者使用的工具如下

Python 3——极其方便的编程语言。选择3.x的版本是因为3.x对中文处理更加友好。

Pandas——Python的一个附加库,用于数据整理。

IE 11——分析页面请求过程(其他类似的流量监控工具亦可)。

剩下的还有requests,re,这些都是Python自带的库。

实例页面(美的某热水器):http://detail.tmall.com/item.htm?id=41464129793

评论在哪里? #

要抓取评论数据,首先得找到评论究竟在哪里。打开上述网址,然后查看源代码,发现里面并没有评论内容!那么,评论数据究竟在哪里呢?原来天猫使用了ajax加密,它会从另外的页面中读取评论数据。

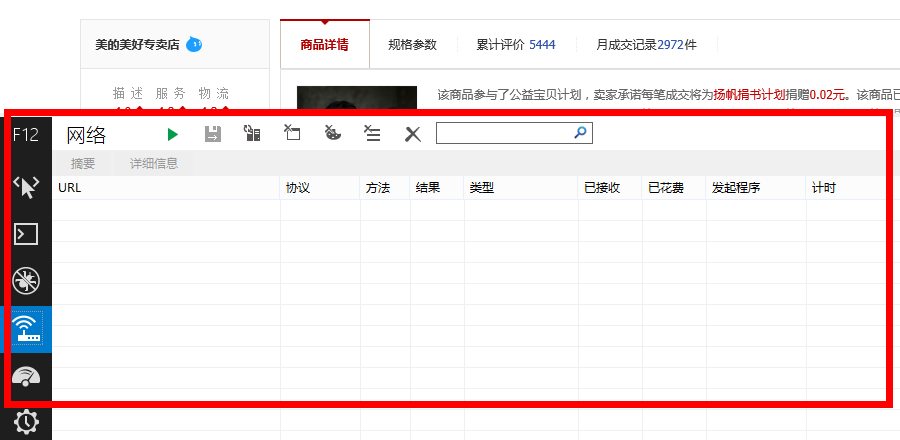

这时候IE 11就发挥作用了(当然你也可以使用其他的流量监控工具),使用前,先打开上述网址,待页面打开后,清除一下IE 11的缓存、历史文件等,然后按F12,会出现如下界面

这时候点击绿色的三角形按钮,启动网络流量捕获(或者直接按F5),然后点击天猫页面中的“累计评价”:

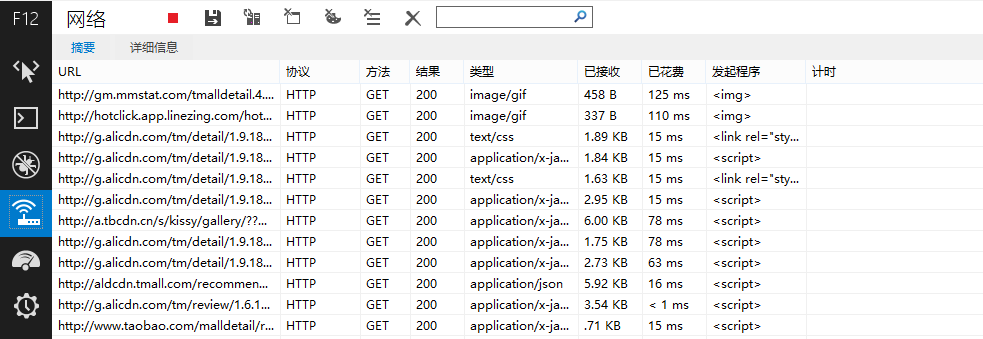

出现如下结果

在URL下面出现很多网址,而评论数据正隐藏在其中!我们主要留意类型为“text/html”或者“application/json”的网址,经过测试发现,天猫的评论在下面这个网址之中

http://rate.tmall.com/list_detail_rate.htm?itemId=41464129793&spuId=296980116&sellerId=1652490016&order=3¤tPage=1&append=0&content=1&tagId=&posi=&picture=&ua=166UW5TcyMNYQwiAiwVQX1EeUR5RH5Cd0xiNGI%3D%7CUm5Ockt1SHxBe0B0SXNOdCI%3D%7CU2xMHDJxPk82UjVOI1h2VngRd1snQSJEI107F2gFfgRlAmRKakQYeR9zFGoQPmg%2B%7CVGhXd1llXGJfa1ZsV2NeZFljVGlLdUt2TXFOc0tyT3pHe0Z6QHlXAQ%3D%3D%7CVWldfS0SMgo3FysUNBonHyMdNwI4HStHNkVrPWs%3D%7CVmhIGCIWNgsrFykQJAQ6DzQAIBwiGSICOAM2FioULxQ0DjEEUgQ%3D%7CV25OHjAePgA0DCwQKRYsDDgHPAdRBw%3D%3D%7CWGFBET8RMQ04ACAcJR0iAjYDNwtdCw%3D%3D%7CWWBAED5%2BKmIZcBZ6MUwxSmREfUl2VmpSbVR0SHVLcU4YTg%3D%3D%7CWmFBET9aIgwsECoKNxcrFysSL3kv%7CW2BAED5bIw0tESQEOBgkGCEfI3Uj%7CXGVFFTsVNQw2AiIeJxMoCDQIMwg9az0%3D%7CXWZGFjhdJQsrECgINhYqFiwRL3kv%7CXmdHFzkXNws3DS0RLxciAj4BPAY%2BaD4%3D%7CX2ZGFjgWNgo1ASEdIxsjAz8ANQE1YzU%3D%7CQHtbCyVAOBY2Aj4eIwM%2FAToONGI0%7CQXhYCCYIKBMqFzcLMwY%2FHyMdKRItey0%3D%7CQntbCyULKxQgGDgEPQg8HCAZIxoveS8%3D%7CQ3paCiQKKhYoFDQIMggwEC8SJh8idCI%3D%7CRH1dDSMNLRIrFTUJMw82FikWKxUueC4%3D%7CRX5eDiAOLhItEzMOLhIuFy4VKH4o%7CRn5eDiAOLn5GeEdnW2VeYjQUKQknCSkQKRIrFyN1Iw%3D%3D%7CR35Dfl5jQ3xcYFllRXtDeVlgQHxBYVV1QGBfZUV6QWFZeUZ%2FX2FBfl5hXX1AYEF9XXxDY0J8XGBbe0IU&isg=B2E8ACFC7C2F2CB185668041148A7DAA&_ksTS=1430908138129_1993&callback=jsonp1994

是不是感觉长到晕了?不要紧,只需要稍加分析,就发现可以精简为以下部分

http://rate.tmall.com/list_detail_rate.htm?itemId=41464129793&sellerId=1652490016¤tPage=1

我们发现天猫还是很慷慨的,评论页面的地址是很有规律的(像京东就完全没规律了,随机生成。),其中itemId是商品id,sellerid是卖家id,currentPage是页面号。

怎么爬取? #

费了一番周折,终于找到评论在哪里了,接下来是爬取,怎么爬取呢?首先分析一下页面规律。

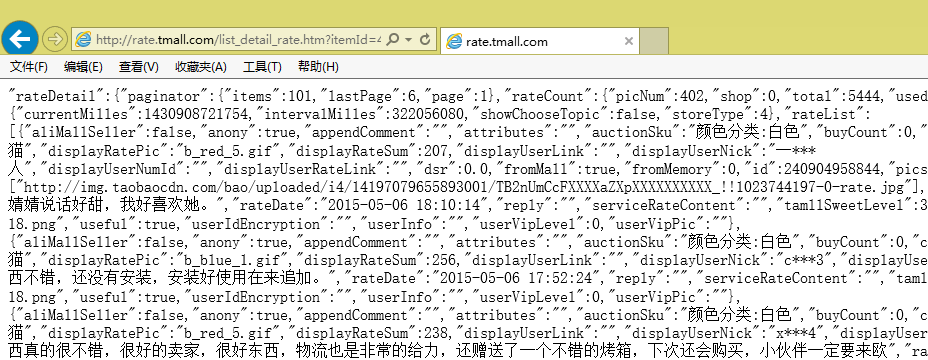

我们发现页面数据是很规范的,事实上,它是一种被称为JSON的轻量级数据交换格式(大家可以搜索JSON),但它又不是通常的JSON,事实上,页面中的方括号[]里边的内容,才是一个正确的JSON规范文本。

下面开始我们的爬取,我使用Python中的requests库进行抓取,在Python中依次输入:

import requests as rq

url='http://rate.tmall.com/list_detail_rate.htm?itemId=41464129793&sellerId=1652490016¤tPage=1'

myweb = rq.get(url)现在该页面的内容已经保存在myweb变量中了,我们可以用myweb.text查看文本内容。

接下来就是只保留方括号里边的部分,这需要用到正则表达式了,涉及到的模块有re。

import re

myjson = re.findall('\"rateList\":(\[.*?\])\,\"tags\"',myweb.text)[0]呃,这句代码什么意思?懂Python的读者大概都能读懂它,不懂的话,请先阅读一下相关的正则表达式的教程。上面的意思是,在文本中查找下面标签

"rateList":[...],"tags"

找到后保留方括号及方括号里边的内容。为什么不直接以方括号为标签呢,而要多加几个字符?这是为了防止用户评论中出现方括号而导致抓取出错。

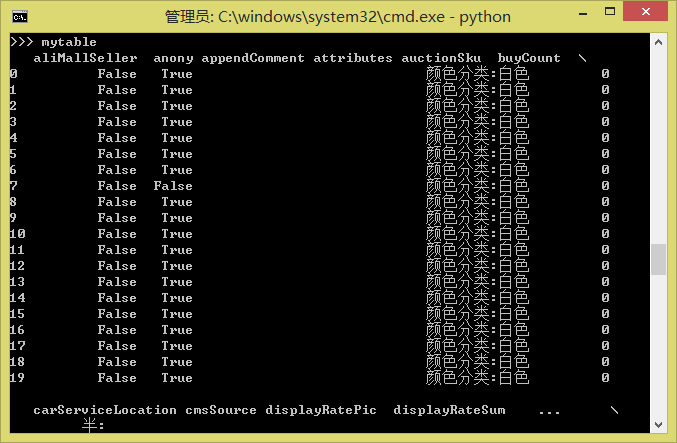

现在抓取到了myjson,这是一个标准的JSON文本了,怎么读取JSON?也简单,直接用Pandas吧。这是Python中强大的数据分析工具,用它可以直接读取JSON。当然,如果仅仅是为了读取JSON,完全没必要用它,但是我们还要考虑把同一个商品的每个评论页的数据都合并成一个表,并进行预处理等,这时候Pandas就非常方便了。

import pandas as pd

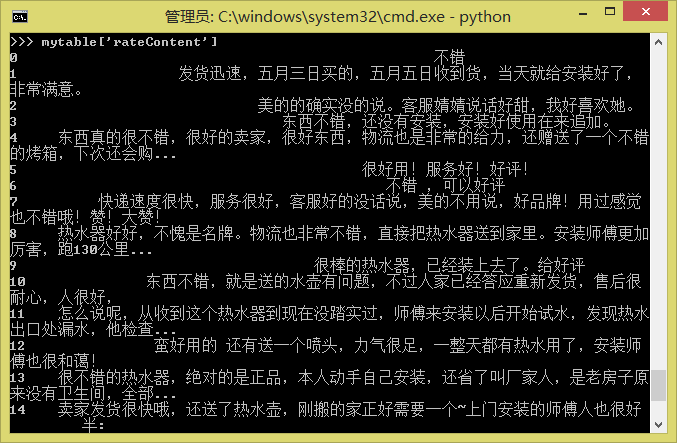

mytable = pd.read_json(myjson)现在mytable就是一个规范的Pandas的DataFrame了:

如果有两个表mytable1和mytable2需要合并,则只要

pd.concat([mytable1, mytable2], ignore_index=True)等等。更多的操作请参考Pandas的教程。

最后,要把评论保存为txt或者Excel(由于存在中文编码问题,保存为txt可能出错,因此不妨保存为Excel,Pandas也能够读取Excel文件)

mytable.to_csv('mytable.txt')

mytable.to_excel('mytable.xls')

一点点结论 #

让我们看看一共用了几行代码?

import requests as rq

import re

import pandas as pd

url='http://rate.tmall.com/list_detail_rate.htm?itemId=41464129793&sellerId=1652490016¤tPage=1'

myweb = rq.get(url)

myjson = re.findall('\"rateList\":(\[.*?\])\,\"tags\"',myweb.text)[0]

mytable = pd.read_json(myjson)mytable.to_csv('mytable.txt')

mytable.to_excel('mytable.xls')

九行!十行不到,我们就完成了一个简单的爬虫程序,并且能够爬取到天猫上的数据了!是不是跃跃欲试了?

当然,这只是一个简单的示例文件。要想实用,还要加入一些功能,比如找出评论共有多少页,逐页读取评论。另外,批量获取商品id也是要实现的。这些要靠大家自由发挥了,都不是困难的问题,本文只希望起到抛砖引玉的作用,为需要爬取数据的读者提供一个最简单的指引。

其中最困难的问题,应该是大量采集之后,有可能被天猫本身的系统发现,然后要你输入验证码才能继续访问的情况,这就复杂得多了,解决的方案有使用代理、使用更大的采集时间间隔或者直接OCR系统识别验证码等等,笔者也没有很好的解决办法。

转载到请包括本文地址:https://www.kexue.fm/archives/3298

更详细的转载事宜请参考:《科学空间FAQ》

如果您还有什么疑惑或建议,欢迎在下方评论区继续讨论。

如果您觉得本文还不错,欢迎分享/打赏本文。打赏并非要从中获得收益,而是希望知道科学空间获得了多少读者的真心关注。当然,如果你无视它,也不会影响你的阅读。再次表示欢迎和感谢!

如果您需要引用本文,请参考:

苏剑林. (May. 06, 2015). 《记录一次爬取淘宝/天猫评论数据的过程 》[Blog post]. Retrieved from https://www.kexue.fm/archives/3298

@online{kexuefm-3298,

title={记录一次爬取淘宝/天猫评论数据的过程},

author={苏剑林},

year={2015},

month={May},

url={\url{https://www.kexue.fm/archives/3298}},

}

December 1st, 2018

请问MangK,现在searchinfo,又变了,变成什么了?

December 2nd, 2018

请问苏老师,这个爬虫的正则表达式,需要重新写,请求老师更正一下,谢谢

January 14th, 2019

前辈,我在用浏览器访问‘http://rate.tmall.com/list_detail_rate.htm'

类似于https://rate.tmall.com/list_detail_rate.htm?itemId=567547047493&spuId=269323491&sellerId=2269638157&order=3¤tPage=1&append=0&content=1

可以得到json格式的所有评价数据,

但是在request里构造请求时只得到这样一串内容:

b'\r\n\r\n\r\n{"rgv587_flag": "sm", "url": "//rate.tmall.com:443/list_detail_rate.htm/tmd/punish?x5secdata=5e0c8e1365474455070961b803bd560607b52cabf5960afff39b64ce58073f7844a8dd94c89edef01763e7bda2153e72fcab45d62d62d1d0fb9af411e98157f55151e037d30b894fa1b9f0617640df860a901a36bd6d324642091753f1253ec47fad7705c7bf26a7ef1aa109e380a620a649c7f900a7c9e502b9d5614b21be76c585d510512f8be4cdb0d4e53b5804dcee26a90a7df58b61f4b6d8769304c257e0496fd369fe90d5a5cb0968745f36293173959473a52df991db9a057aa860e6ec7493fb62f9278e24f1101ec2a88496be64fe7c2b8f69454c3030f98912b20e57c906a34cd3389933259d1cdc60837267dab14593dfc4341433f7b16aa8ec901a66fc14f736ed45bc53517cde99db61ef652477ccb4bf7caafe10e57362d226cd6a27906d66221653de01d0c8621b7f55c9edda4450e5b8708806aa671a4bb3bcfb0c3aefac537538fb3c4518b2f3cc9bebe3999de89b715520fa7bf25efa24321bd982834025777f5d720b283432993f456a22bf2ab1f7cadbabe78d5bcac1c8747672219c71927eaae354887c77e001fce86cdaa9e9e50d6a8840aaf1539b42d6e3a3ddb9e15bb061459785a2b3abd84ada87e0d005666d68b20cea0d4894f2c53536e9489411b502b55c0f1e4c5a525b1a51e4ab381cd6589a57191a0d0c46662f2e043fac6bdb5b6990fa12f362185212ea6d4095c1d950656f095716aa6a7ceb02f25da156336197406ca10a517e4e20aa809bea00d717761a53df4306e3f286ae6f6898c4920396e71c09c9077057b2ae6d61c87a6cc6d32237eeff75d7a120df11d0c4875c33717cea47bf9c5d9a678964b11679bf2531504047e854&x5step=2"}'

这是怎么回事呢?

逐一把浏览器的所有header加到模型请求中去,看看缺哪个。

嗯嗯,我错在没有保持登录,我把cookie加到header里,再访问就成功返回评论了。

不过,我获取cookie是通过在浏览器手动登录,把cookie复制到代码中实现的。

事实上,我并不能在代码中实现登录天猫,用post方法把用户名TPL_username和密码TPL_password发到http://login.taobao.com,结果返回500错误。

是因为天猫反爬太厉害了吗。。。

September 1st, 2019

你好,我想请教一下,我用浏览器访问类似http://rate.tmall.com/list_detail_rate.htm'

类似于https://rate.tmall.com/list_detail_rate.htm?itemId=567547047493&spuId=269323491&sellerId=2269638157&order=3¤tPage=1&append=0&content=1地址却没办法看到Jason格式评论,只能看到{"rgv587_flag": "sm", "url": "//rate.tmall.com:443/list_detail_rate.htm/_____tmd_____/punish?x5secdata=5e0c8e1365474455070961b803bd560607b52cabf5960afff39b64ce58073f7844a8dd94c89edef01763e7bda2153e72fcab45d62d62d1d0fb9(不是完整的)这种内容要怎么办呢

本文仅传授方法,所给url地址不保证永远可行,请按照本文方法自行探索。

September 21st, 2019

现在淘宝反爬虫越来越高级了,需要在header中加入cookie才能访问到真是的url了。

好的,感谢提供这个信息

July 30th, 2020

点赞!

October 25th, 2020

2020年10月25日阅读打卡

遇到这个博客真是万幸!

November 19th, 2022

[...]转载到请包括本文地址:http://spaces.ac.cn/archives/3298/[...]

November 19th, 2022

[...]转载到请包括本文地址:http://spaces.ac.cn/archives/3298/[...]